在机器人技术不断发展的今天,如何让机器人更好地理解和适应三维物理环境,成为了研究者们关注的焦点。

最近,来自上海AI Lab、TeleAI和上科大等团队的研究人员提出了一种名为SpatialVLA的空间具身通用操作模型,旨在解决现有机器人操作策略在三维空间理解上的不足。

传统的通用操作模型多依赖于二维输入,缺乏对三维环境的深刻理解。这使得它们在面对光照变化、视角差异和环境不一致等问题时,表现得相对脆弱。

而人类则能够凭借丰富的空间认知能力,在不同的场景中灵活地操作物体。

因此,如何为视觉-语言-动作(VLA)模型赋予强大的三维空间理解能力,成为了当前机器人研究领域的一大挑战。

图1:我们介绍了 SpatialVLA,这是一种空间增强的视觉-语言-动作模型,已在 110 万个真实机器人事件中进行了训练。模型配备 3D 以自我为中心的位置编码和自适应空间网格,用于探索通才机器人策略的空间表示,实现卓越的 3D 场景空间理解,零镜头 分布内泛化,并有效适应新的机器人设置。该模型在各种评估中实现了最先进的性能,并显示出显著的 推理速度更快,每次作的令牌更少。

SpatialVLA模型通过百万真实数据的预训练,成功探索了空间表征在具身通用操作中的潜力。

该模型的核心在于对齐的空间表示,它能够处理来自不同机器人形态的观察数据,并将这些数据转化为可执行的动作。

具体来说,SpatialVLA通过Ego3D位置编码来感知三维世界,将图像的语义特征与三维空间上下文相结合。

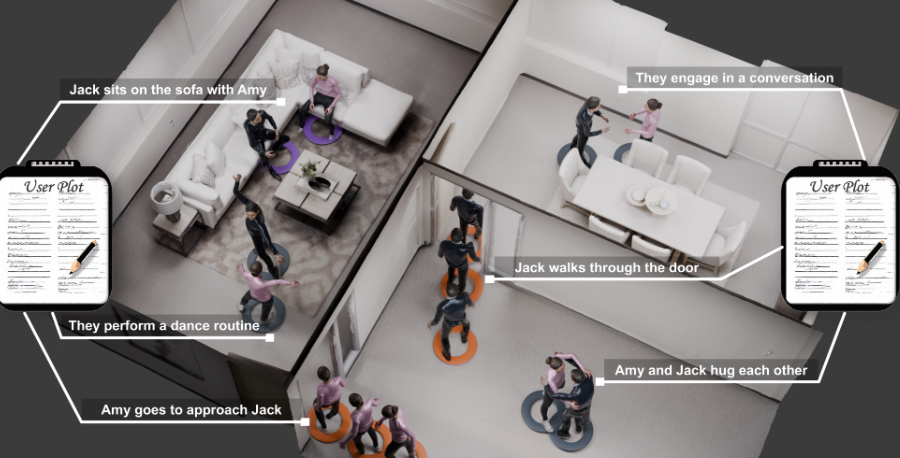

图2:SpatialVLA 的管道。给定图像观测 和自然语言任务指令 ,模型会处理 使用 Ego3D 位置编码进行图像观察,并自动回归预测被去标记化为连续动作的空间动作标记 用于机器人控制。这模型由三个关键组件组成:(1) 模型首先用 SigLIP 视觉编码器提取 2D 语义特征,然后用 Ego3D 位置编码注入 3D 空间上下文;(2) 的 空间动作运动由统一的自适应动作网格离散化,并用单独的空间动作标记表示以进行预测;(3) 动作网格和空间动作 代币能够进行调整和更新,以有效适应新的机器人设置。

这一过程消除了对特定机器人相机校准的需求,使得模型在各种机器人平台上都能广泛适用。

此外,SpatialVLA还采用了自适应动作网格,将连续动作离散化为基于任务数据的自适应网格。

这使得不同机器人之间的动作与三维物理世界的结构得以有效对齐。

模型的后期训练阶段,动作网格和空间嵌入能够根据新的环境进行调整,展现出卓越的适应能力。

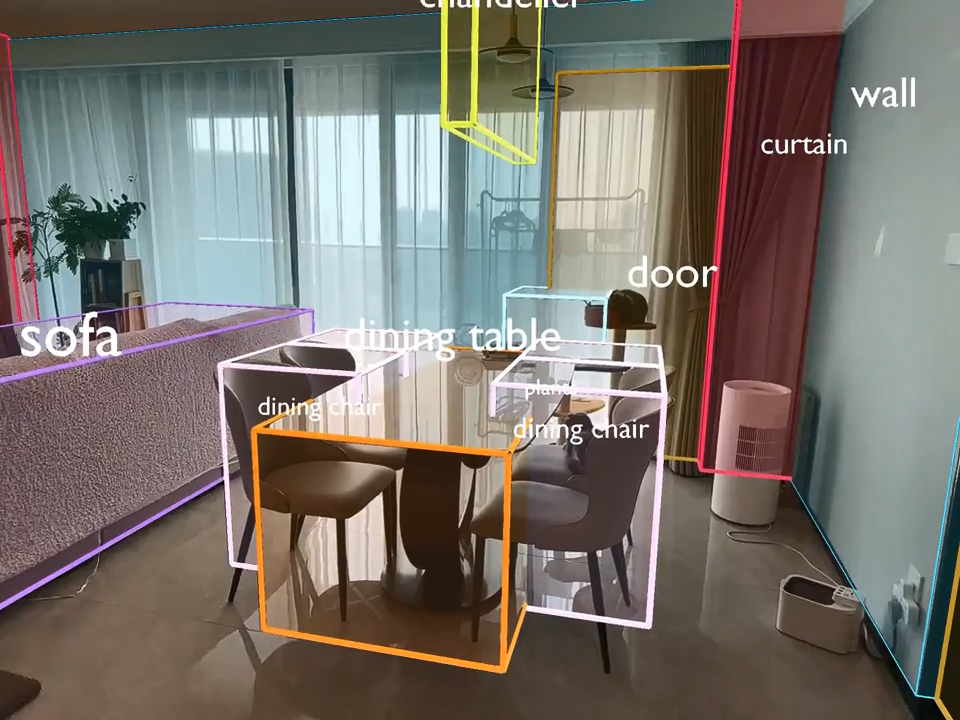

在实验中,团队在七种不同的机器人学习场景中评估了SpatialVLA的能力,涵盖了真实机器人任务和仿真环境。

图3:我们在 7 个机器人学习场景、16 个真实机器人任务和 48 个仿真设置中评估了 SpatialVLA,重点关注三个关键方面:零镜头 控制、空间理解和对新设置的适应性。我们还对 Fractal 和 Bridge 混合数据集进行了彻底的消融研究,以验证我们的设计决策。

结果显示,该模型在零样本泛化控制、新场景高效微调和空间理解能力等方面都取得了最先进的性能。

例如,在WidowX机器人平台上,SpatialVLA在未见过的场景中表现出了较高的成功率,能够根据语言提示准确执行任务。